Nuestro enfoque hacia la IA generativa se basa en un profundo respeto por la creatividad humana. Está diseñada para potenciar —no reemplazar— y creada con un compromiso firme con una innovación responsable que pone al creador en primer lugar.

En Chaos, creemos que la IA debería potenciar la creatividad humana, no reemplazarla. Nuestras herramientas de IA están diseñadas para brindar a arquitectos, ingenieros, contratistas y artistas visuales capacidades que amplían su imaginación y eficiencia a la vez que protegen su autoría y originalidad.

A medida que la IA generativa se convierte en un elemento clave del diseño y la visualización, nuestro compromiso es claro: impulsar la innovación sin comprometer —y respetando— a los creadores, protegiendo la propiedad intelectual y aportando claridad ética y legal en cada paso.

Diseñamos nuestra IA como plataformas cocreativas: los profesionales tienen el control sin que esto perjudique el poder de la IA. Su objetivo es amplificar la creatividad, no perjudicarla.

Así es como nos aseguramos de que nuestro enfoque siga siendo juicioso, responsable y centrado en el creador:

Veras y el mejorador mediante IA de Chaos usan Stable Diffusion, que se entrenó sobre la base de imágenes y leyendas tomadas de LAION-5B, un conjunto de datos público que deriva de los datos Common Crawl que se obtienen de la web. Para otros modelos, solo usamos conjuntos de datos que sean de código abierto y aptos para uso comercial, o que tengan la licencia adecuada para nuestro uso.

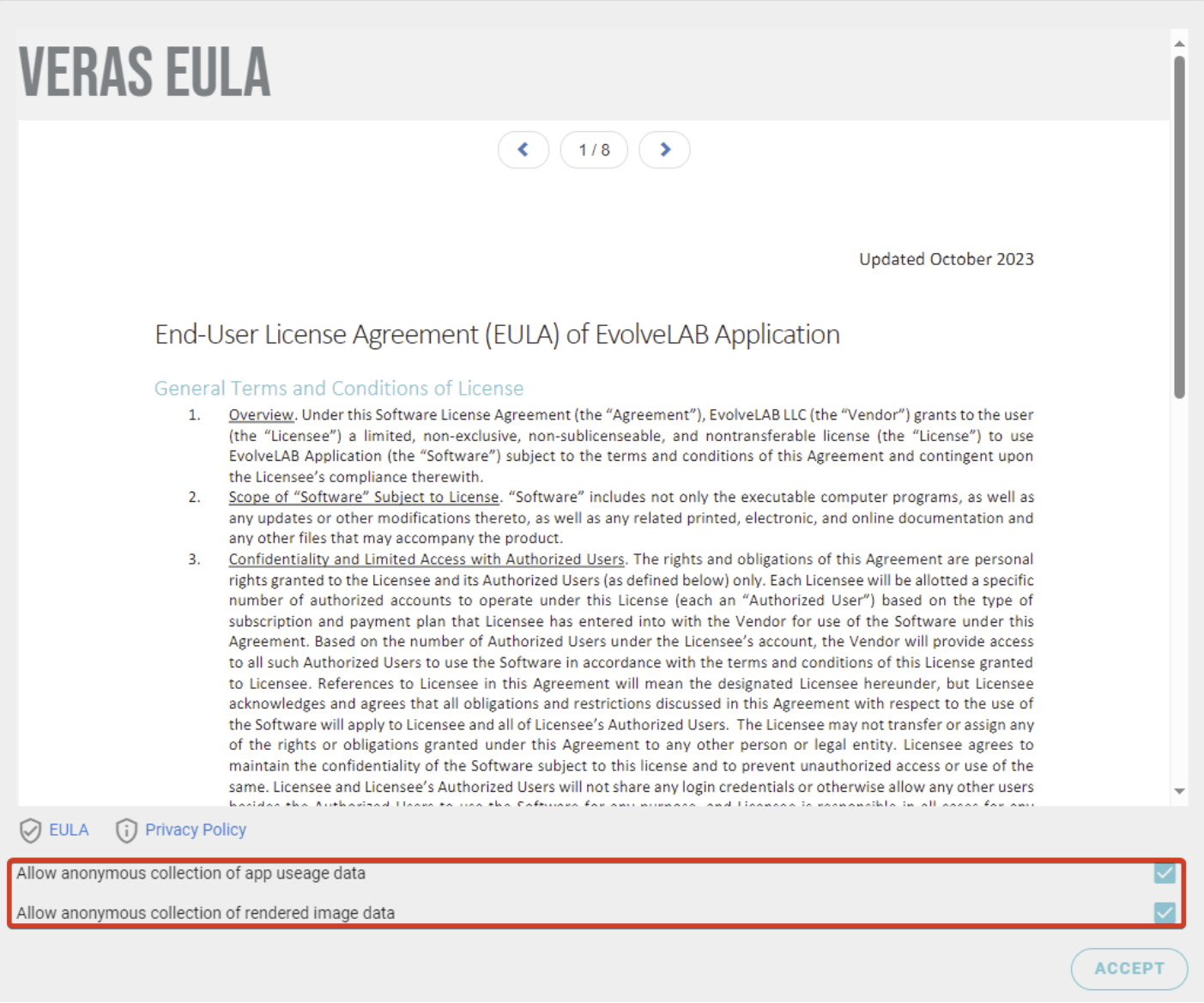

En Veras y Glyph, los datos anónimos de uso y renderizado solo se recopilan si decides compartirlos. Puedes desactivar esta opción durante la instalación o de forma general para Veras y Glyph siguiendo nuestra guía de configuración para TI. En el caso del mejorador mediante IA, las imágenes recibidas y generadas se guardan de forma anónima únicamente con fines de control de calidad y diagnóstico.

Siempre que tus contratos lo permitan y respetes las condiciones de los modelos o recursos de terceros que uses.

Chaos no reclama la propiedad del contenido generado.

Nuestras herramientas de IA promueven la autoría humana. Para agilizar el proceso creativo, usan la información que proporcionas y te dan control sobre la semilla, los prompts, los ajustes y los resultados, manteniendo siempre el aporte humano necesario para la protección de derechos de autor según la legislación de EE. UU.

Cada funcionalidad de IA que diseñamos refleja nuestro compromiso con la equidad, la seguridad y la responsabilidad, sin frenar el ritmo de la innovación. Estos principios no están al margen: forman la base de nuestra filosofía de producto desde el inicio.

Datos de entrenamiento éticos

Seleccionamos los datos de entrenamiento con cuidado y, para ello, utilizamos conjuntos de datos curados que responden a las necesidades específicas de la visualización arquitectónica. En lugar de extraer contenido de forma indiscriminada de la web, usamos material con licencias adecuadas, relevante para el contexto y alineado con estándares profesionales y estilos de diseño diversos. Nuestro objetivo es fomentar la creatividad sin comprometer la integridad.

Calidad a través de pruebas continuas

Antes de lanzar cualquier funcionalidad de IA, la sometemos a pruebas rigurosas, tanto con sistemas automatizados como mediante revisión humana directa. Este proceso no termina con el lanzamiento. Seguimos evaluando el desempeño en entornos reales para asegurar que los resultados sigan siendo confiables, precisos y acordes con las expectativas de los usuarios.

Supervisión ética desde el diseño

Cada funcionalidad de IA que desarrollamos pasa por un proceso de revisión estructurado, que combina la evaluación técnica con una diversidad de puntos de vista humanos. Esto nos permite identificar de forma proactiva riesgos, como sesgos o afirmaciones inexactas, y crear herramientas que respondan con equidad, ética y atención a las necesidades de una amplia diversidad de usuarios.

Los comentarios como fuerza impulsora

Tu opinión influye directamente en cómo mejoramos. Los foros comunitarios y los programas alfa y beta, así como los encuentros y las mesas redondas con clientes específicos, nos permiten mantenernos conectados con tus experiencias. Este diálogo constante garantiza que nuestra IA evolucione según las necesidades de los usuarios y se mantenga siempre cercana a la realidad.

A medida que la IA se integra cada vez más en los flujos de trabajo de diseño y visualización, comprendemos lo esencial que se ha vuelto la transparencia respecto a la propiedad intelectual (PI) y la seguridad de los datos. Esta sección de preguntas frecuentes está diseñada para explicar de manera clara cómo se gestionan tus datos y qué derechos conservas al usar las herramientas impulsadas por la IA de Chaos.

Cubrimos nuestras tres herramientas clave de IA:

Cada herramienta se desglosa en dos áreas críticas: la propiedad intelectual detrás de los datos de entrenamiento y las medidas implementadas para proteger tus datos durante su uso. Nuestro objetivo es brindarte confianza y claridad mientras exploras lo que la IA puede desbloquear en tu proceso creativo. Si tienes más preguntas, no dudes en contactarnos. Estaremos encantados de ayudarte.

Según la Oficina de Derechos de Autor de EE. UU., el contenido generado por la IA se puede proteger mediante derechos de autor siempre que un humano haya contribuido a la imagen o la haya editado de manera significativa: lee la guía oficial aquí. Veras utiliza tu modelo 3D y la vista de cámara como base visual (“sustrato”) para el renderizado, lo que significa que el resultado se basa directamente en tu contenido original. Además, tú aportas intervención humana mediante la creación de indicaciones (prompts), el bloqueo de semillas (seed locking) y la selección del renderizado; por eso, se considera que el proceso es una coautoría. Estos elementos de intervención humana, inherentes al uso de Veras, alinean firmemente cualquier resultado con los requisitos de contenido protegible por derechos de autor según la guía de la Oficina de Derechos de Autor de Estados Unidos.

En la Unión Europea, el enfoque está puesto más en la originalidad de la obra. Diferentes países pueden aplicar umbrales ligeramente distintos sobre lo que se considera suficiente intervención humana o creatividad original. Por ello, aunque la participación humana es clave, el tratamiento legal exacto puede variar de país a país.

Podemos asegurar que Chaos no reclama la propiedad de los resultados que creas usando Veras. Sin embargo, sí podemos conservar ciertos derechos limitados para usar dichos resultados, principalmente para hacer uso de nuestros productos y servicios, y para mejorarlos. Además, podemos imponer ciertas limitaciones en el uso de nuestros productos, servicios y contenido (por ejemplo, prohibir usos que infrinjan la legislación aplicable o que impliquen la creación de representaciones físicas de nuestro contenido propietario). Puedes encontrar el texto exacto en nuestro Acuerdo de licencia y servicios.

Tus derechos sobre los resultados dependen de varios factores, especialmente del contexto en que hiciste el renderizado (por ejemplo, si fue de forma independiente, como parte de tu trabajo o bajo un contrato con un cliente), así como de los derechos que terceros puedan tener sobre el modelo o los recursos que usaste.

Veras funciona con Stable Diffusion, que se entrenó con el conjunto de datos LAION, un gran banco público de imágenes y textos recopilados de internet.

No. Lo que genera Veras no es una copia de ninguna imagen específica del entrenamiento. El modelo genera contenido completamente nuevo con base en la estructura de tu diseño 3D y tus indicaciones textuales. Mientras lo que ingreses sea tuyo, el resultado es tuyo.

Para el renderizado, Veras envía a la nube solo los datos esenciales (vista de cámara y captura de la geometría).

A ti. El mejorador de IA aplica mejoras visuales a tus propios renderizados. No introduce contenido nuevo ni altera la intención de tu diseño, por lo que la propiedad intelectual sigue siendo completamente tuya.

El mejorador de IA funciona con Stable Diffusion, que se entrenó con el conjunto de datos LAION —un banco de imágenes y textos de gran escala, público y recopilado de fuentes en internet—, además de técnicas de procesamiento de imágenes de código abierto, como eliminación de ruido y mejora de detalles. No se entrena con contenido generado por usuarios ni introduce imágenes externas.

Almacenamos las imágenes de entrada y salida en Estados Unidos y las utilizamos solo con fines de control de calidad y diagnóstico, según lo establecido en el Contrato de licencia de usuario final (CLUF). Estos datos no se utilizan para entrenamiento, ni hay planes de hacerlo.

A ti. Glyph funciona completamente dentro de tu entorno BIM y genera resultados (vistas, planos, etiquetas y cotas) basados en tu modelo. Los resultados se generan a partir de prompts e información que proporcionas, y permanecen dentro de tu proyecto y bajo tu control.

Glyph Copilot utiliza ChatGPT de OpenAI (GPT-4) para ayudarte a ejecutar tareas y paquetes dentro de Glyph. El modelo de lenguaje se entrenó con una amplia variedad de datos públicos en internet y no incorpora contenido de clientes.

Glyph no utiliza tus datos para volver a entrenar o ajustar el modelo.

No; sin embargo, en el CLUF nos reservamos la opción de hacerlo en el futuro. Al iniciar la aplicación por primera vez, verás dos casillas que puedes desactivar si no deseas permitir la recopilación anónima de imágenes, prompts y datos de uso de la aplicación.

Para desactivar esta opción a nivel global, los profesionales de TI pueden seguir estas instrucciones: https://forum.evolvelab.io/t/installing-veras-msi-configurations-remote-deployment-for-it-managers/4717